Warum Linux in Unternehmen oft nicht am Betriebssystem scheitert

Die Diskussion rund um Windows 11 und vermeintlich „zu alte“ Hardware greift häufig zu kurz. Technisch ist längst klar: Viele Linux-Distributionen laufen stabil, sicher und performant auf Hardware, die von Windows offiziell nicht mehr unterstützt wird. Trotzdem bedeutet das nicht automatisch, dass Unternehmen problemlos auf Linux umsteigen können.

Das eigentliche Problem ist selten eine grundsätzliche Ablehnung von Linux in IT-Abteilungen. Im Gegenteil: Linux ist dort allgegenwärtig – auf Servern, in der Cloud und in der Infrastruktur. Die Hürde liegt fast immer woanders: bei gewachsener, oft selbstgebauter Legacy-Software.

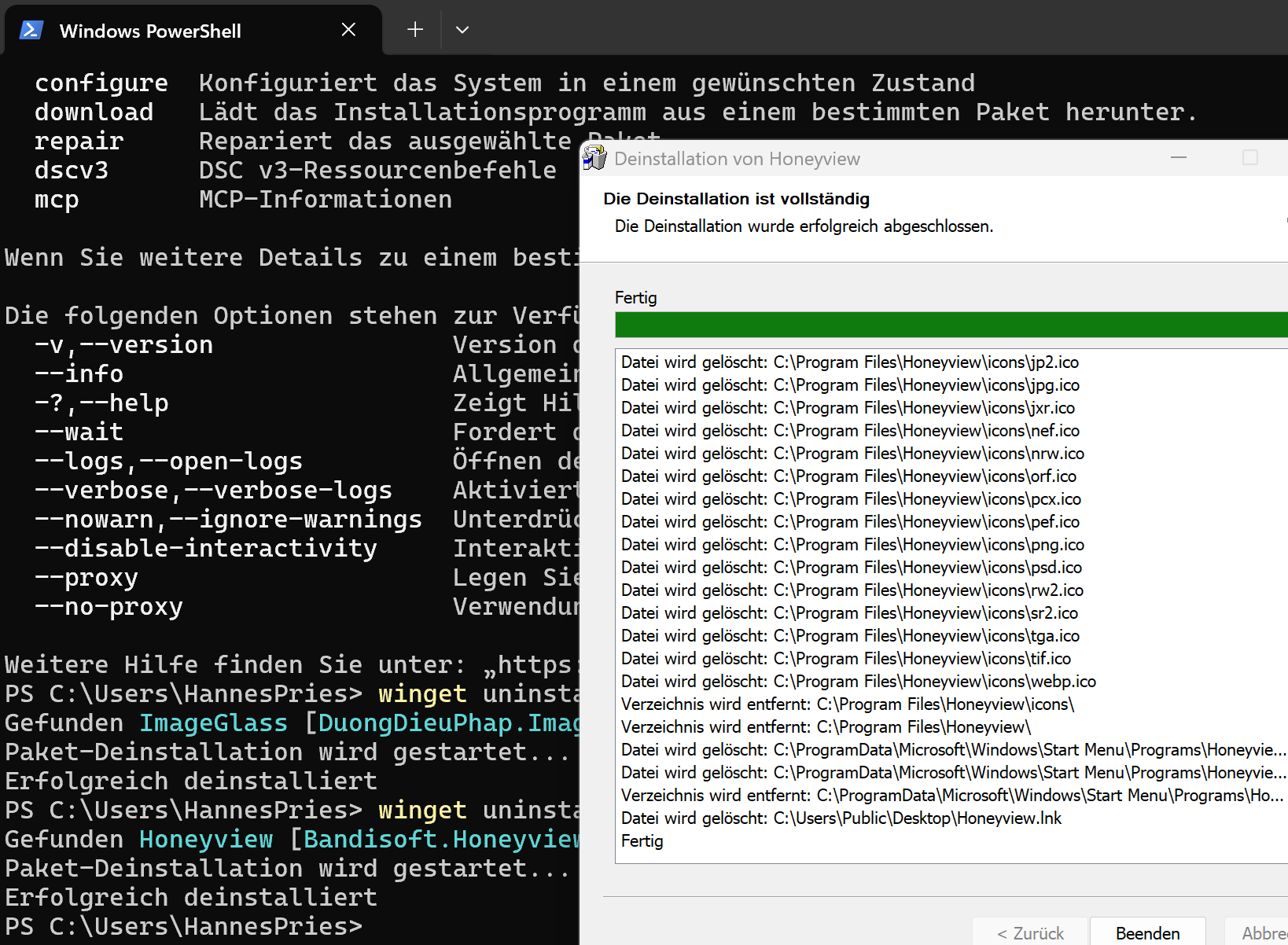

In vielen Unternehmen existieren Anwendungen, die gerade noch unter Windows 10 funktionieren, aber stark an die Windows-Plattform gebunden sind. Native Win32-Programme, hart kodierte Pfade, Abhängigkeiten von Netzlaufwerken, speziellen Druckertreibern oder einer lokal installierten Office-Version sind keine Ausnahme. Für solche Software ist Linux – selbst mit Wine – entweder keine realistische Option oder nur mit unverhältnismäßig hohem Aufwand.

Hinzu kommt Drittanbieter-Software, für die es außerhalb von Windows keinen Support gibt. Selbst wenn eine Anwendung technisch lauffähig wäre, fehlt oft die rechtliche oder vertragliche Absicherung. In produktiven Umgebungen ist das ein entscheidender Faktor.

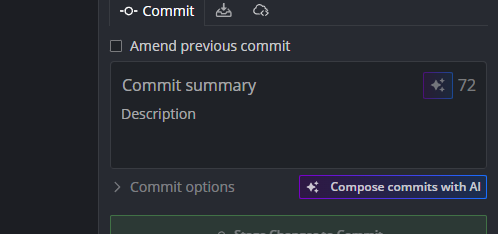

Unternehmen, die frühzeitig auf browserbasierte Anwendungen gesetzt haben, sind hier klar im Vorteil. Wenn der Arbeitsalltag vollständig im Web stattfindet und ein aktueller Chrome oder Firefox genügt, wird das Betriebssystem weitgehend irrelevant. In diesen Fällen ist Linux auf dem Desktop tatsächlich eine sehr realistische Alternative.

Der oft zitierte Vendor-Lock-in ist daher weniger ein Problem einzelner Hersteller als das Ergebnis jahrelanger Architekturentscheidungen. Wer sich heute schwer tut, ist meist nicht von außen gezwungen worden – sondern hat sich das Problem selbst gebaut.

bezahlt von

bezahlt von